O termo “inteligência artificial” (IA) foi cunhado por John McCarthy em 1955, em uma proposta de conferência de verão para o Dartmouth College, nos Estados Unidos.

McCarthy, juntamente com Marvin Minsky, Nathaniel Rochester e Claude Shannon, organizaram o evento com o objetivo de explorar formas de fazer com que máquinas simulassem aspectos da inteligência humana. A conferência, que só aconteceu em 1956, é amplamente reconhecida como o marco oficial do nascimento da IA como um campo de estudo independente.

A ideia de máquinas inteligentes não é nova. Filósofos e cientistas já especulavam sobre a possibilidade de criar autômatos pensantes há séculos.

No século 17, René Descartes sugeriu que seria possível construir uma máquina capaz de imitar o comportamento humano. No século 19, Charles Babbage e Ada Lovelace trabalharam na concepção de máquinas computacionais programáveis que poderiam, teoricamente, exibir comportamentos inteligentes.

No entanto, foi apenas no século XX, com o avanço da eletrônica e da computação, que a IA começou a se tornar uma possibilidade concreta.

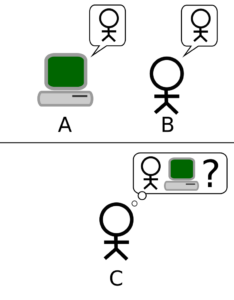

Alan Turing, em 1950, propôs o famoso Teste de Turing como um critério para avaliar a inteligência de uma máquina. Essa ideia influenciou significativamente o desenvolvimento da IA e reforçou o interesse em formalizar um campo de pesquisa dedicado ao tema.

Representação esquemática do Teste de Turing: o humano (C) interage com o computador (A) e com outro humano (B), sem saber quem é quem, tentando descobrir qual dos dois é a máquina. Crédito: Hugo Férée / Wikimedia Commons

Após a conferência de Dartmouth, o termo “inteligência artificial” tornou-se amplamente aceito e serviu para definir um novo ramo da ciência da computação.

Nas décadas seguintes, a IA passou por períodos de avanços e retrocessos, conhecidos como “invernos da IA”, quando o entusiasmo inicial deu lugar a desafios técnicos e limitações computacionais.

Por outro lado, a relação entre emoções, consciência e inteligência tem sido um tema central na neurociência e na filosofia da mente.

Antonio Damasio, um dos mais influentes neurocientistas contemporâneos, argumenta que as emoções desempenham um papel essencial na formação da consciência e no desenvolvimento da inteligência.

Suas pesquisas desafiaram visões tradicionais que colocavam razão e emoção como forças opostas, demonstrando que a emoção não apenas influencia, mas é um elemento constitutivo da cognição humana.

Damasio propõe que a consciência emerge a partir de processos biológicos profundamente enraizados na interação entre o organismo e seu ambiente.

Em sua obra O Erro de Descartes (1994), ele questiona a dicotomia cartesiana entre mente e corpo, mostrando que as emoções são fundamentais para a tomada de decisões e para a construção da identidade consciente.

Damasio também argumenta que a inteligência não pode ser dissociada das emoções. Em O Sentimento de si – O corpo, a emoção e a neurobiologia da consciência (1999) e Em busca de Espinosa (2003), ele demonstra que a emoção é um mecanismo evolutivo fundamental para a sobrevivência, permitindo que os organismos tomem decisões adaptativas.

O conceito de “marcadores somáticos” é central nesse argumento: experiências passadas deixam registros emocionais no cérebro, que ajudam na tomada de decisões futuras ao gerar respostas automáticas e intuitivas a determinadas situações.

Estudos de Damasio com pacientes que sofreram danos na região do córtex pré-frontal ventromedial — área do cérebro localizada na região da testa e associada à regulação emocional — revelaram que indivíduos sem capacidade de experimentar emoções apropriadas tinham dificuldade em tomar decisões racionais.

Isso sugere que a inteligência, longe de ser um processo puramente lógico, depende da interação entre emoção e cognição.

As descobertas de Damasio têm implicações profundas para a inteligência artificial (IA) e para a compreensão da natureza humana.

No campo da IA, questiona-se se uma máquina pode alcançar a inteligência real sem incorporar mecanismos emocionais semelhantes aos humanos.

Se emoções são fundamentais para a tomada de decisões e para a construção da consciência, então a construção de uma IA verdadeiramente autônoma e consciente exigiria a replicação desses processos.

Além disso, sua teoria sugere que qualquer tentativa de compreender a inteligência humana deve levar em conta não apenas a lógica e a razão, mas também os aspectos emocionais e biológicos.

Ora, grande parte do que chamamos de IA, hoje, não “entende” ou é consciente do que faz. São modelos matemáticos que reconhecem padrões e produzem resultados a partir de dados, mas não possuem a experiência subjetiva ou o entendimento profundo que associamos à inteligência humana ou a outras formas de vida.

DeepSeek vs. ChatGPT: entenda como são treinadas e por que IA chinesa muda o jogo

De fato, a maioria dos sistemas de IA resolve problemas específicos (por exemplo, classificar imagens, gerar texto, recomendar produtos), baseando-se em algoritmos estatísticos e redes neurais. Embora esses sistemas possam alcançar resultados impressionantes, isso não significa que possuam inteligência geral ou que sejam capazes de raciocinar de forma autônoma e universal.

Igualmente, a ideia de “artificial” pode sugerir algo totalmente independente de processos naturais, mas as IAs atuais dependem integralmente de dados fornecidos e de modelos projetados por humanos.

Em vez de serem “artificiais” no sentido de algo completamente separado, as IAs podem ser vistas como ferramentas construídas por pessoas para amplificar a capacidade de análise, tomada de decisão e criação.

Desse ponto de vista, seriam uma continuação ou extensão da própria inteligência humana, ainda que operando por meio de computadores.

Mais ainda, o debate sobre o que é ou não é “inteligência” perpassa campos como filosofia da mente, ciências cognitivas e neurociência, e ainda não há consenso nem uma definição absoluta.

Portanto, quando afirmamos que não é “inteligência” utilizamos uma forma de ressaltar que há diferenças fundamentais entre a cognição humana/animal e o que as máquinas realizam.

Ou seja, embora o termo “inteligência artificial” seja histórico e persuasivo, ele claramente também traz confusões. Por isso, alguns preferem termos como “aprendizado de máquina” ou “sistemas de aprendizado estatístico” para refletir melhor o que essas tecnologias realmente fazem.

Também lembramos que a responsabilidade final sobre as decisões envolvendo IA continua sendo humana, justamente porque os sistemas dependem de dados históricos (muitas vezes enviesados) e não têm julgamento moral ou compreensão contextual.

O fato é que as máquinas atuais, por mais avançadas que sejam, ainda estão longe de reproduzir aspectos centrais do que entendemos por “inteligência” (como autoconsciência, compreensão profunda e raciocínio criativo).

Além disso, a sua designação como “artificial” pode ignorar o quanto esses sistemas são, na prática, um produto da inteligência humana, sendo treinados e alimentados com dados do mundo real.

Essas considerações servem para que a sociedade não se deixe levar pelo fascínio de nomes e promessas. Isso é importante para que haja regulação apropriada, conscientização de limites e discussão ética sobre os impactos do uso dessas ferramentas.

Enquanto isso, navegando nas inovações de IA, as grandes empresas de tecnologia – as chamadas “big techs” – vêm expandindo suas operações de forma acelerada e conquistando espaços cada vez mais centrais nas economias e sociedades ao redor do mundo.

Essa expansão, embora promova inovações significativas e facilite a vida dos consumidores, traz também preocupações acerca do poder desproporcional que essas corporações adquirem, levantando riscos para a soberania e o bem-estar dos países.

Um dos perigos mais evidentes é o monopólio do conhecimento e dos dados. Quando um pequeno número de empresas controla plataformas de busca, redes sociais, comércio eletrônico e outras infraestruturas críticas, cria-se uma dependência tecnológica quase irreversível.

Na prática, isso reduz a possibilidade de competição local, sufoca o surgimento de concorrentes menores e torna os países vulneráveis às decisões de negócios – muitas vezes de caráter global e alheias às demandas regionais.

Além disso, o fato de essas corporações coletarem e processarem imensas quantidades de dados em escala global, utilizando as ferramentas de IA, significa que podem influenciar a maneira como as pessoas pensam, consomem e até votam, impactando aspectos fundamentais da vida em sociedade.

Outro risco se manifesta na influência política e regulatória exercida pelas gigantes tecnológicas.

Com imensos recursos financeiros e presença mundial, essas companhias conseguem pressionar governos e moldar leis em favor de seus próprios interesses.

Leia também: Os desafios do Brasil para alcançar soberania digital na Era das Big Techs

A soberania dos países, então, é colocada em xeque, pois muitas vezes faltam conhecimento técnico e mecanismos de fiscalização robustos para conter possíveis abusos. Essa assimetria de poder limita a capacidade de atuação dos governos em estabelecer regras que protejam os cidadãos, como legislações de proteção de dados, garantias trabalhistas e taxação justa.

Em meio a esses desafios, ressaltam-se também as implicações na esfera cultural e social. O domínio de poucos canais de comunicação pode homogeneizar a produção cultural e veicular desinformação ou discursos de ódio sem a devida responsabilização.

Ademais, modelos de recomendação tendem a criar “bolhas” de informação, onde usuários são expostos apenas a conteúdos que reforçam suas opiniões prévias, dificultando o diálogo e a construção de uma esfera pública saudável. Nesse contexto, comunidades inteiras podem perder visibilidade, e a pluralidade de vozes fica prejudicada.

Diante desse cenário, a ação coordenada entre os países torna-se crucial.

Medidas como a criação de leis de proteção de dados mais rigorosas, a promoção de ecossistemas de inovação nacionais e a cooperação internacional para fiscalizar e regular o poder dessas corporações são fundamentais.

Só assim será possível equilibrar a necessidade de desenvolvimento tecnológico com a proteção dos direitos dos cidadãos, preservando a soberania dos países e garantindo que a tecnologia sirva ao bem comum.

Allan Kardec Duailibe Barros Filho, 55 anos, é doutor em engenharia da informação pela Universidade de Nagoya (Japão). É professor titular da UFMA (Universidade Federal do Maranhão). Foi diretor da ANP (Agência Nacional do Petróleo, Gás Natural e Biocombustíveis) e atualmente é presidente da Gasmar (Companhia Maranhense de Gás)